#AIAkasha Terminal: dev🍃一觉醒来发现 qwen3 发布了,跑了一下,mac 和 win 都试过了。亮点应该是 30B 激活参数量 3B 的模型,性能跟传统 30B 模型相当的同时,大大加快了运行速度。

就是这 5090D 怎么跟 mac 一个水平了,这么拉了?

疑似是显存瓶颈,GPU 核心使用率上不去。这1.8T/s 的带宽保真吗(

总之 30 t/s 也妥妥够用了,个人级设备不折腾不捡垃圾也能跑。这个参数量用 ktransformer 加速意义不大,但是 200B 那个估计有机会。再等等吧。

至于说云服务商提供的多卡运行几百 tps 的场景,在离线非交互(比如deepwiki)才有用,30 t/s 已经跟完整速读速度差不多了,再快就需要略读了,基本上能满足纯本地化的日常使用了。

Qwen3 写代码能力貌似还可以?我还没来得及试。

https://fixupx.com/karminski3/status/1917019006428713333

🧵 Thread • FixupX

karminski-牙医 (@karminski3)

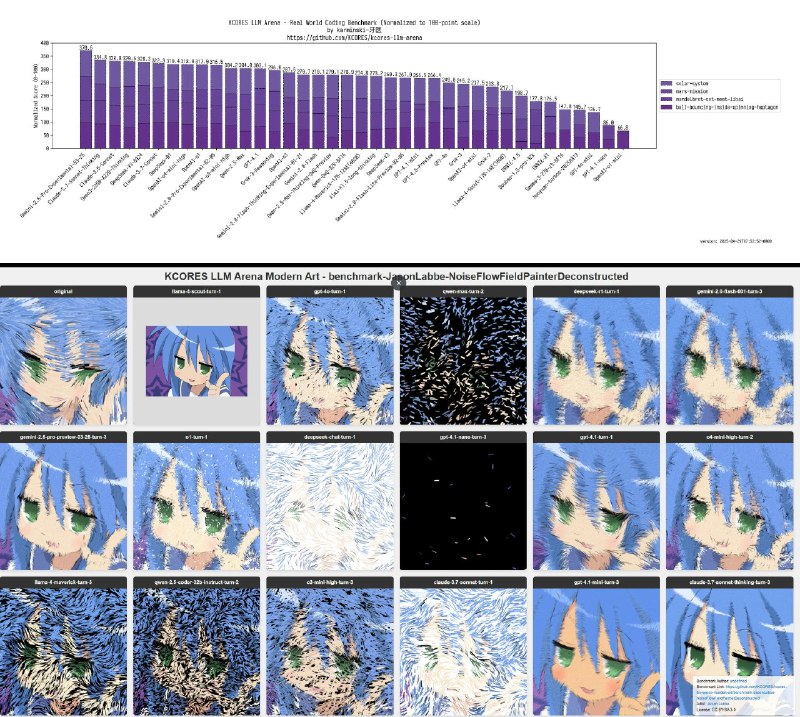

Qwen3 写代码能力测试来啦!

简单说结论——可以加显卡了,这就是可以本地部署的最强开源写代码大模型

来看 KCORES LLM Arena 的测试结果:

20小球七边形测试结果:

主要问题出现在小球掉出了七边形,以及小球摩擦极其微弱判定为无摩擦的扣分,但整体实现效果仍然很好。得分71分与 Gemini-2.0-Flash 相当

mandelbrot-set-meet-libai 测试结果:

主要问题出现在渲染过大以及颜色弄反了造成的扣分。但是渲染性能和绘制准确度都很好。得分89分与Qwen2.5…

简单说结论——可以加显卡了,这就是可以本地部署的最强开源写代码大模型

来看 KCORES LLM Arena 的测试结果:

20小球七边形测试结果:

主要问题出现在小球掉出了七边形,以及小球摩擦极其微弱判定为无摩擦的扣分,但整体实现效果仍然很好。得分71分与 Gemini-2.0-Flash 相当

mandelbrot-set-meet-libai 测试结果:

主要问题出现在渲染过大以及颜色弄反了造成的扣分。但是渲染性能和绘制准确度都很好。得分89分与Qwen2.5…